NVIDIA与OpenAI宣布达成战略合作。根据合作意向书,NVIDIA将以分阶段方式投入1000亿美元,支持OpenAI建设以NVIDIA AI芯片为核心的数据中心集群。OpenAI计划部署至少10GW的NVIDIA AI芯片系统,用于下一代模型训练与推理。首个达到GW规模的系统,预计在2026年下半年于NVIDIA的Vera Rubin平台上线。这组信息构成了合作的“金额—容量—时间—平台”四个关键锚点,说明双方意在把算力作为下一阶段能力边界的直接变量来布局。

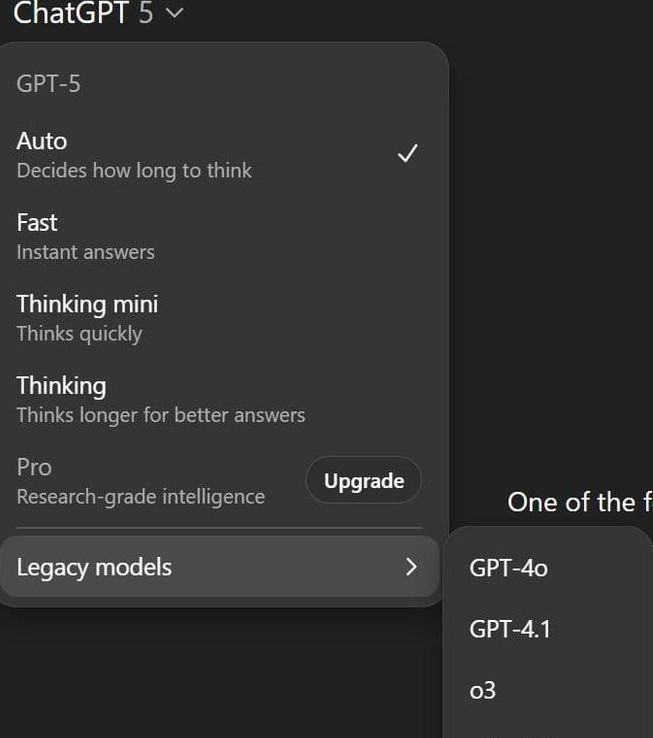

NVIDIA方面给出的量级对照,使外部更易感知体量。10GW对应约400万至500万片GPU,接近NVIDIA一个自然年的总出货量,并且是去年的两倍。数值背后,是产能组织、供应链协同与软件栈同步推进的系统工程。OpenAI得到的是可预测的算力曲线;NVIDIA得到的是面向自身体系的需求锁定与路线图协同。

双方管理层的表态聚焦在两点:其一,合作延续过往十年的配合路径,从早期DGX到ChatGPT,再到本次基础设施协同,节奏明确且相互绑定更深;其二,把“算力即经济基础”作为共同判断,将投资与建设放在同一逻辑链条上。这也解释了为何要在此时确认大额投入与容量目标:模型规模、数据规模与工程复杂度的抬升,要求更集中、可调度、可扩展的基础设施。

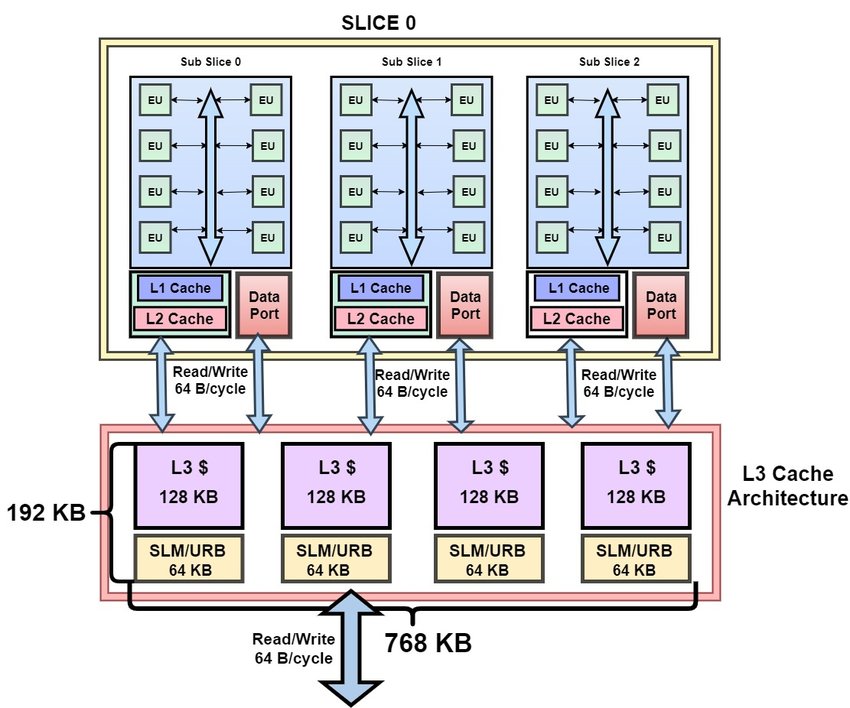

合作范围不仅是硬件。协议显示,NVIDIA将作为OpenAI的“首选运算与网络合作伙伴”,双方将协同优化模型、基础设施软件以及硬件发展路线。这意味着软硬件将以同一节拍演进:模型训练需求反向影响芯片与网络拓扑设计;框架与驱动的演进又反向提升算力利用率。这种“双向校准”旨在降低大规模系统中的摩擦损耗,让投资更快转化为可用性能。

业内解读把这次合作放进更宏观的竞争坐标:它不仅是技术协作,也是利益结盟。更具体地说,资金路径与采购路径形成了闭环。NVIDIA出资,目标对象是OpenAI的算力建设;OpenAI按计划扩张集群,而核心硬件来自NVIDIA。就经济关系而言,这接近一种“自投自售”的模式:投资推动需求,需求反哺销量,销量强化生态黏性。对NVIDIA,这是对未来芯片出货与平台地位的前置下注;对OpenAI,这是对长期算力供给与路线图稳定性的提前锁定。

风险与不确定性同样存在。OpenAI当前商业化仍在深化过程中,算力消耗高而现金回流节奏不确定;NVIDIA需要在产能、交付与生态支持之间保持长期均衡,以避免“投入快、兑现慢”的结构性压力。也因此,项目采用分阶段投资与分期部署,可以在节点上进行质量与效率复盘,降低一次性承诺带来的执行风险。

总体来看,这笔1000亿美元的合作,将“资金—产能—软件—模型”的链路收束到一个共同时间表上。短期内,它提供确定性的算力扩张路径与协同机制;中期,它强化了双方在AI基础设施层的绑定;长期,它会通过生态与工具链向外扩散影响力。对关注产业走向的读者而言,接下来更值得跟踪的是三个信号:Vera Rubin平台在2026年下半年的系统交付节奏;10GW目标对应的集群可用性能与能效指标;以及“首选合作伙伴”框架下的软件栈优化进度。这三项将决定资金投入转化为有效算力与实际产出的速度。