阅读量:221

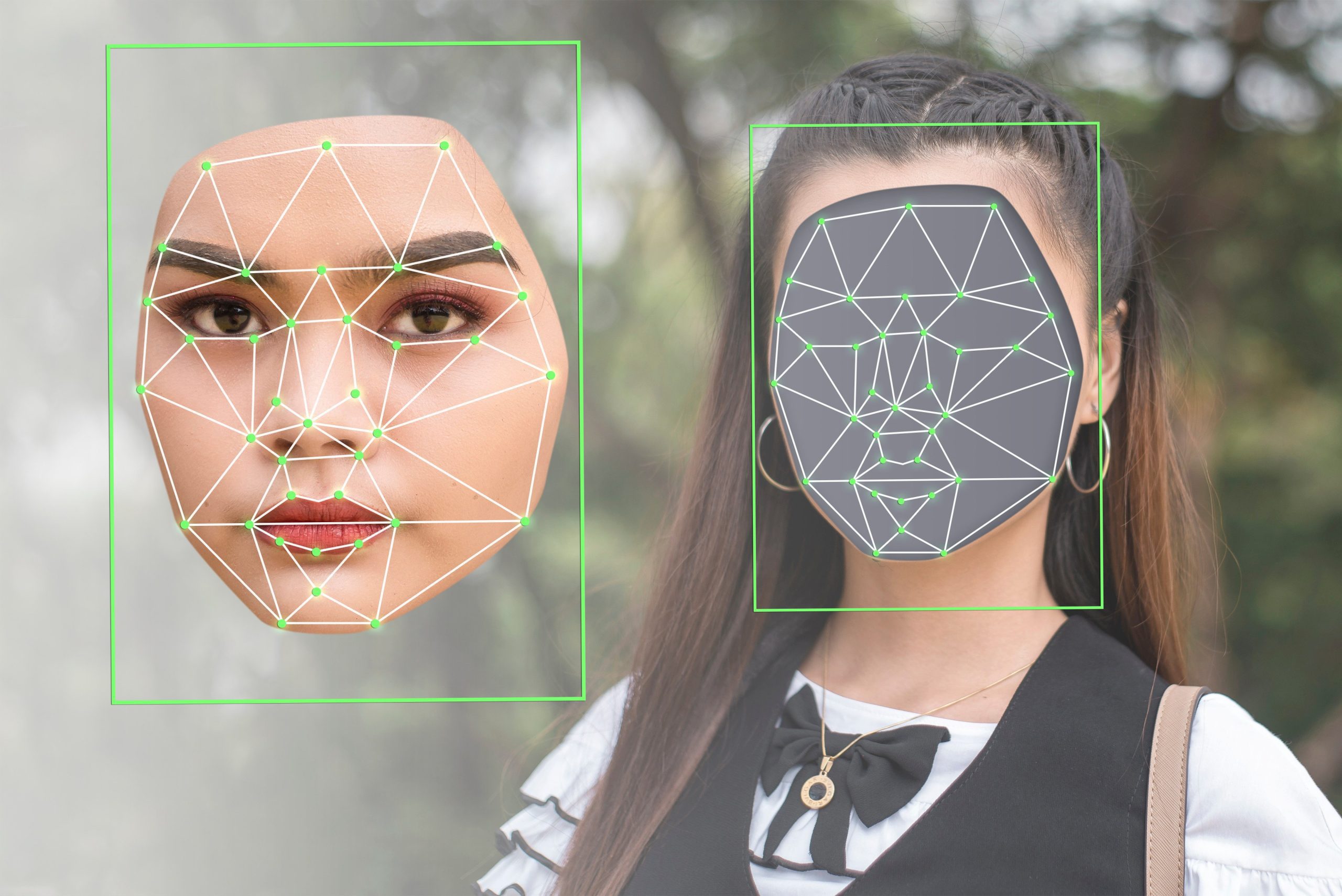

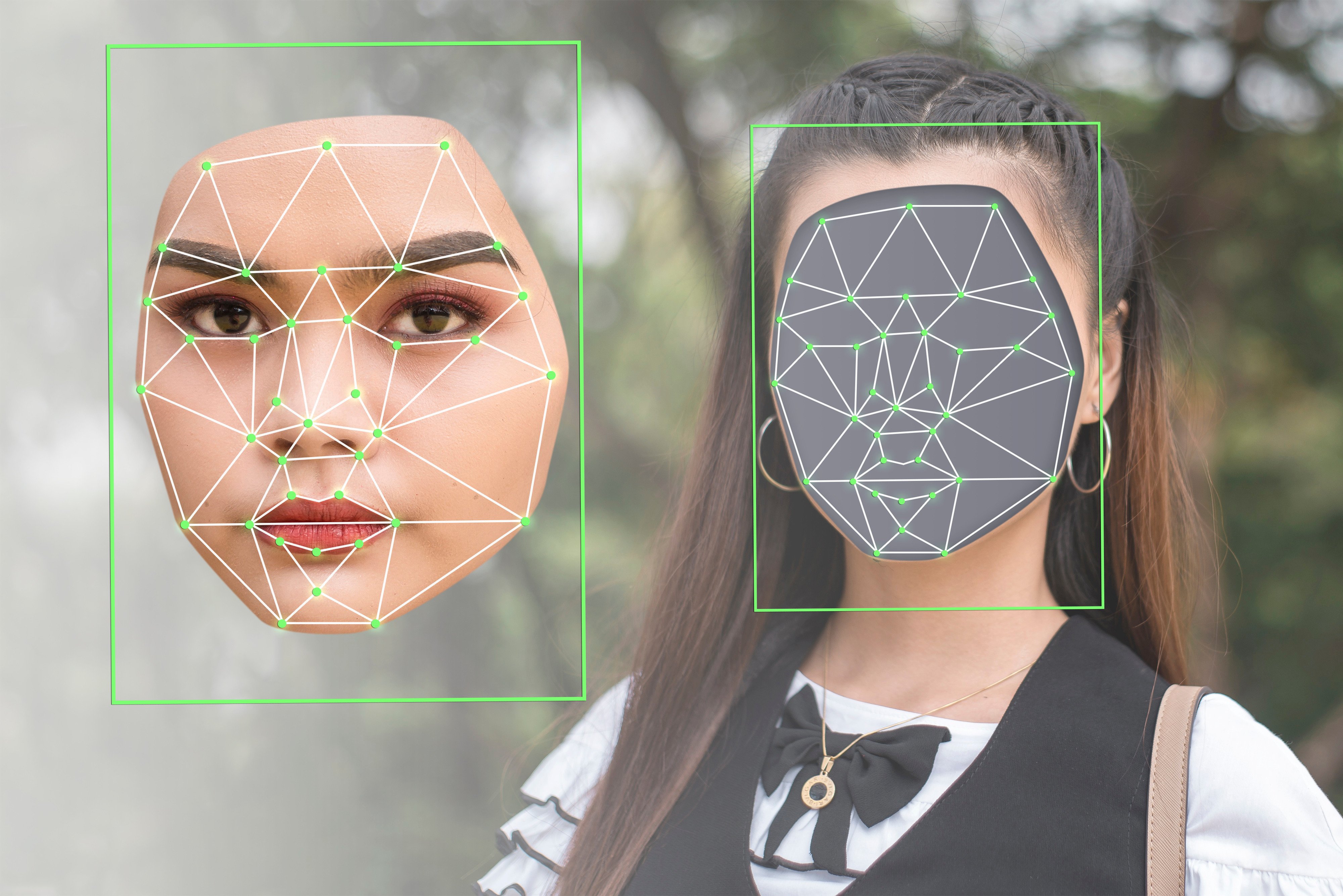

AI这玩意儿真是把子啊,一方面帮咱们省事儿,另一方面也让一些人脑洞大开,干起歪门邪道来了。就在前几天,日本媒体放出个大新闻:一个31岁的普通上班族,竟然靠AI工具生成女明星、偶像和主播的“深假”色情图片卖钱,短短几个月就捞了120万日元以上的黑心钱,结果被警方抓了个现行。这事儿一出,网上炸锅了,大家都在吐槽科技的双刃剑。

事情得从今年年初说起。警方本来是注意到这家伙在1月到6月间发了3张这样的图片,才盯上他的。没想到一逮捕,搜查他家时挖出的大料可不少——原来从去年10月开始,他就偷偷摸摸用AI生成了两万多张类似图片,受害者多达262人,包括不少知名女艺人、偶像和直播达人。这些图片不是随便糊弄的,看起来“惟妙惟肖”,难怪能卖出高价。

这哥们儿被抓后,还死鸭子嘴硬,辩解说自己只是做了些“长得像”的图片,没直接用受害者的真脸套上去。警方可不吃这套,目前案件还在审理中,估计得好好掰扯掰扯什么是“酷似”和“侵权”的界限。话说回来,这不光是日本的孤例,全球范围内AI滥用生成假裸照的案子越来越多,受害者大多是女性公众人物,隐私权和名誉都遭殃。

案情小结:

- 涉案时间:从2024年10月持续至今,峰值在2025年上半年。

- 图片数量:超过2万张。

- 受害人数:262位女星/偶像/主播。

- 非法收入:超120万日元(约合人民币6万多)。

- 嫌疑人辩词:仅“酷似”,非真实套图。

这事儿也提醒咱们,AI工具用着方便,但得守规矩啊。平台和法律得跟上趟儿,不然类似悲剧还得重演。你怎么看?欢迎留言讨论!

四人组