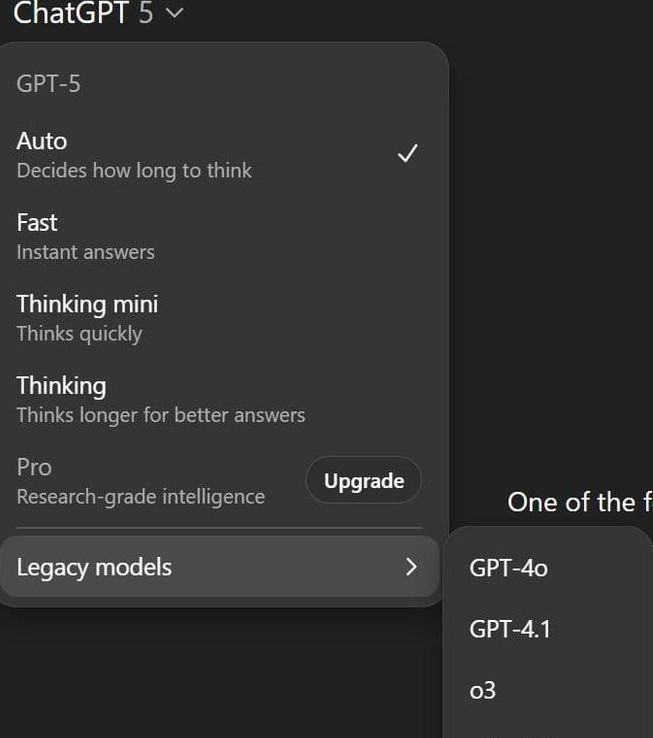

一句话捋清:OpenAI 正在推进多款 AI 硬件,原型里有掌心大小、无屏幕的智能设备,但真正拦路虎不是外观,而是算力与底层基础设施。这不是道听途说,内部口径直指“算力是延期的关键因素”。

现在卡在哪儿?

-

算力捉襟见肘:消息人士说得很直白——亚马逊 Alexa、谷歌都能给到足额算力,OpenAI 这边连 ChatGPT 的日常供给都紧张,更别提再扛一条智能设备产品线。

-

设备形态很激进:没有屏幕,只靠摄像头、麦克风、扬声器一直待机,随时响应。听起来科幻,但背后意味着常开推理、隐私治理、云边协同都要拉满。团队也在权衡“AI 的性格设定”和隐私边界。

为什么是现在?

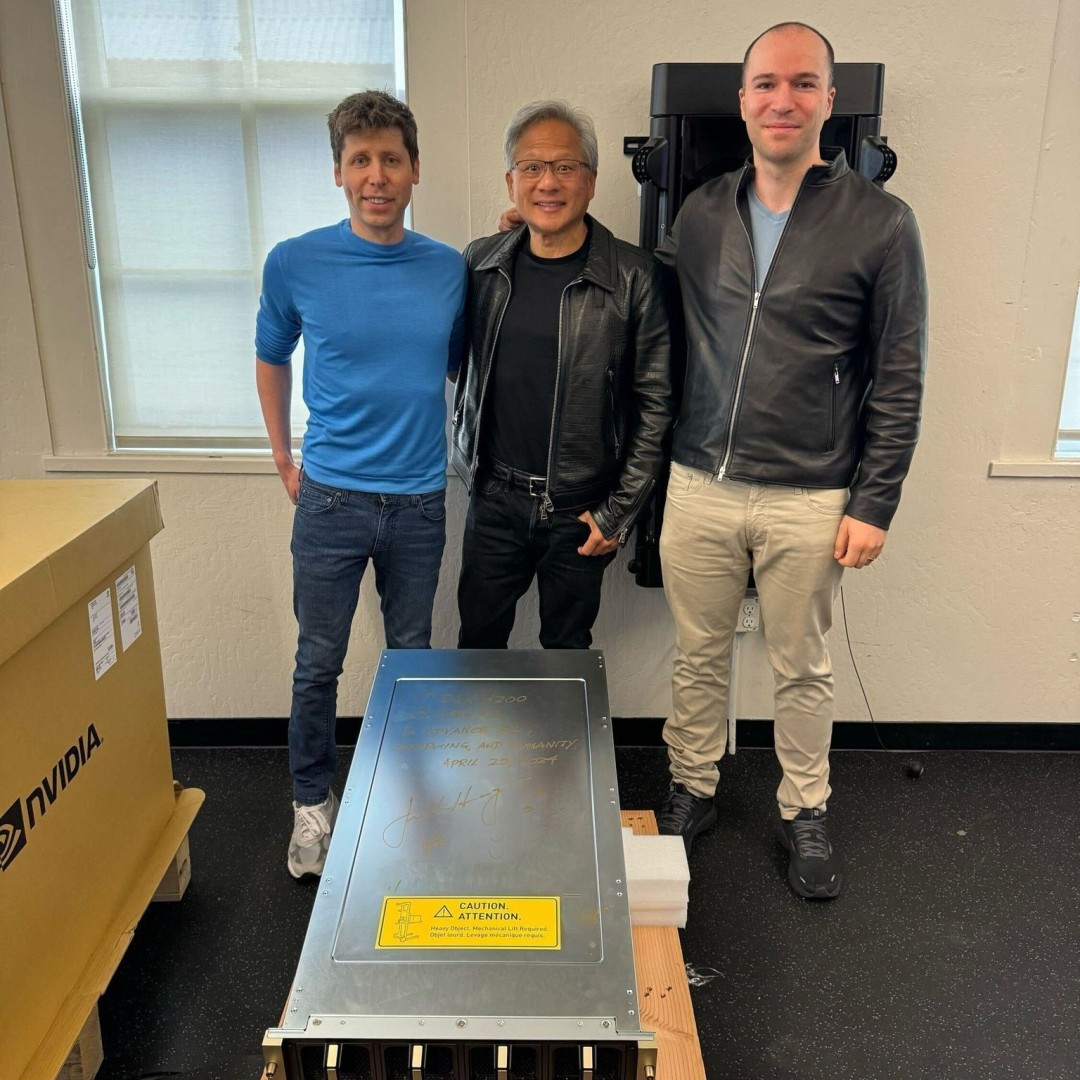

今年 5 月,OpenAI 用65 亿美元全股票把 Jony Ive 创立的新公司 io 收到麾下,等于是把“工业设计+硬件团队”一次性装机,进军 AI 终端的旗子插稳了。

什么时候能见到?

如果节奏顺,明年下半年有望先看到一台智能音箱产品落地。注意,这只是一个保守的时间窗,前提依旧是算力和基础设施啃得动。

解题思路:算力从哪儿来?

-

“外补”路线:OpenAI 已经把算力问题往产业链里“前置绑定”——和 AMD 签了多代 GPU 的大单协作,路线从 MI450 开始,继续延展到后续产品,等于把训练/推理的供给稳定性锁上。

-

利益深绑:协议里还有最多 1.6 亿股AMD 认股权证,里程碑跟 1GW→6GW 的部署规模挂钩,把双方动机拧成一股绳。

做这类“无屏”AI设备,算力到底烧在哪儿?

-

低时延对话:用户说一句、设备回一句,背后是连续的小型推理链路,云端要抗洪,本地 NPU/小加速器也得兜底。

-

持续感知:全天候麦克风/摄像头监听触发词,意味着常开模型或边缘轻量模型轮值,耗电和发热都是真问题。

-

个性化画像:如果想让设备“懂你”,就要做个人化适配与长记忆管理,存储、推理成本都会放大。

-

隐私合规:哪些在端侧算、哪些上云,怎么匿名化、怎么留审计线,都要工程化落地;这部分并不比做一个“漂亮外壳”简单。

我们能合理期待什么?

-

先上云、再下沉:早期版本更像“云优先”的语音/多模态助手,后续再把高频、可预测的推理挪到本地。

-

功能先收敛:第一代不必贪大求全,把“听懂—响应—稳态运行”打磨到家,更现实。

-

与生态协同:结合手机/电脑端 App 形成“设备+账号”的连续体验,用服务把硬件粘性拉起来。

一句话收尾

OpenAI 的硬件,不会倒在“外形设计”,瓶颈在成本可控的连续算力。当训练、推理与供应确定性逐步补齐,那个“没屏幕却很能干”的小家伙,才有机会真正走进大家家里客厅。